Elastic Fabric Adapter(EFA)는 Amazon EC2 인스턴스의 네트워크 인터페이스입니다. 이 인터페이스를 사용하면 AWS에서 대규모로 높은 수준의 노드 간 통신이 필요한 애플리케이션을 실행할 수 있습니다. EFA는 사용자 지정 운영 체제(OS) 바이패스 기술을 사용하여 인스턴스 간 통신 성능을 강화합니다. 이는 이러한 애플리케이션을 확장하는 데 매우 중요합니다. EFA를 사용하면 메시지 전달 인터페이스(MPI)를 사용하는 고성능 컴퓨팅(HPC) 애플리케이션 및 NVIDIA Collective Communications Library(NCCL)를 사용하는 기계 학습(ML) 애플리케이션을 통해 수천 개의 CPU 또는 GPU로 확장할 수 있습니다. 따라서 온프레미스 HPC 클러스터의 애플리케이션 성능과 더불어 AWS 클라우드의 온디맨드 탄력성과 유연성을 얻을 수 있습니다.

EFA는 EC2 네트워킹 기능 옵션으로 제공되며 추가 비용 없이 지원되는 모든 EC2 인스턴스에서 활성화할 수 있습니다. 또한 노드 간 통신을 위해 가장 일반적으로 사용되는 인터페이스, API 및 라이브러리와 함께 작동하므로 변경 없이 HPC 애플리케이션을 AWS로 마이그레이션할 수 있습니다.

장점

보다 빠른 결과

EFA의 고유한 OS 바이패스 네트워킹 메커니즘은 인스턴스 간 통신을 위한 지연 시간이 짧고 지터가 적은 채널을 제공합니다. 이를 통해 긴밀하게 연결된 HPC 또는 분산형 기계 학습 애플리케이션을 수천 개의 코어로 확장하여 애플리케이션을 더 빠르게 실행할 수 있습니다.

유연한 구성

EFA를 지원하는 EC2 인스턴스의 목록이 계속해서 증가하고 있으므로 워크로드에 적합한 컴퓨팅 구성을 유연하게 선택할 수 있습니다. 요구 사항이 변함에 따라 클러스터 구성을 변경하고 새 컴퓨팅 인스턴스에서 EFA 지원을 활성화하기만 하면 됩니다. 사전 예약이나 사전 계획이 필요하지 않습니다.

원활한 마이그레이션

EFA는 통신을 위해 libfabric 인터페이스와 libfabric API를 사용합니다. 거의 모든 HPC 프로그래밍 모델이 이 인터페이스를 지원하므로 수정 없이 기존 HPC 애플리케이션을 클라우드로 마이그레이션할 수 있습니다.

EFA 성능

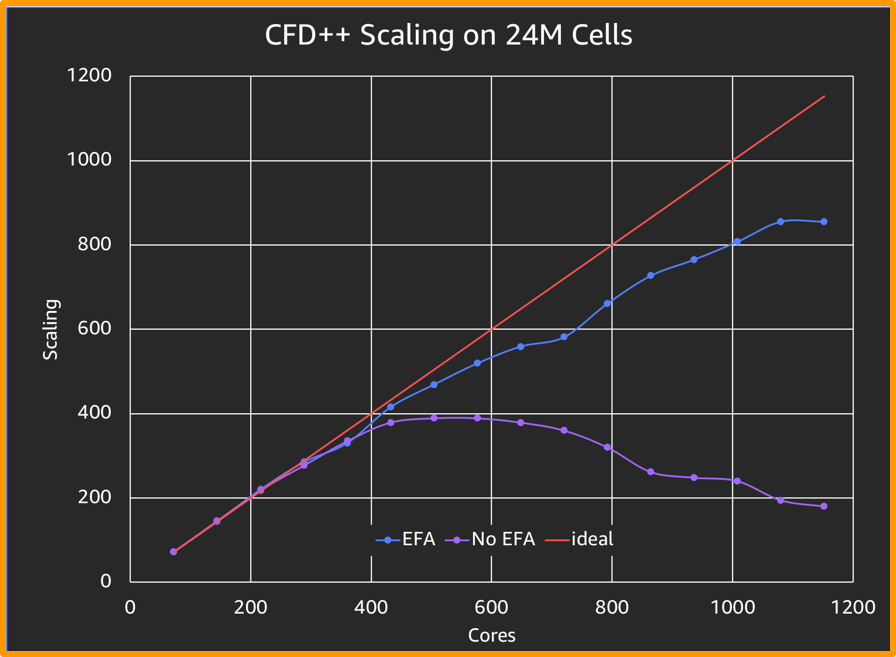

EFA는 위의 차트에서 볼 수 있듯이 표준 CFD 시뮬레이션에서 ENA보다 4배 향상된 스케일링을 제공합니다.

Metacomp Technologies가 제공하는 이 벤치마킹용 솔루션

작동 방식

사용 사례

전산 유체 역학(CFD)

전산 유체 역학(CFD) 알고리즘의 발전으로 엔지니어는 점점 더 복잡해지는 흐름 현상을 시뮬레이션할 수 있으며 HPC는 처리 시간을 줄이는 데 도움이 됩니다. 이제 설계 엔지니어는 EPA를 사용하 더 많이 조정할 수 있는 파라미터로 실험하도록 시뮬레이션 작업을 확장할 수 있으며, 더 빠르고 더 정확한 결과를 얻을 수 있습니다.

날씨 모델링

복잡한 기상 모델에는 정확한 결과를 제공하기 위해 높은 메모리 대역폭, 빠른 상호 연결 및 강력한 병렬 파일 시스템이 필요합니다. 모델의 그리드 간격이 가까울수록 결과가 더 정확해지고 모델에 더 많은 계산 리소스가 필요합니다. EFA는 날씨 모델링 애플리케이션이 AWS 클라우드의 사실상 무제한 확장 기능을 활용하고 더 짧은 시간에 더 정확한 예측을 얻을 수 있도록 하는 빠른 상호 연결을 제공합니다.

기계 학습

GPU 기반 분산형 컴퓨팅을 사용하면 딥 러닝 모델 학습을 크게 가속화할 수 있습니다. Caffe, Caffe2, Chainer, MxNet, TensorFlow 및 PyTorch와 같은 선도적인 딥 러닝 프레임워크는 이미 NCCL을 통합하여 노드 간 통신을 위한 다중 GPU 집합을 활용했습니다. EFA는 AWS 기반 NCCL에 최적화되어 이러한 교육 모델의 처리량과 확장성을 개선함으로써 더 빠른 결과를 제공합니다.

리소스