Cos'è il caching?

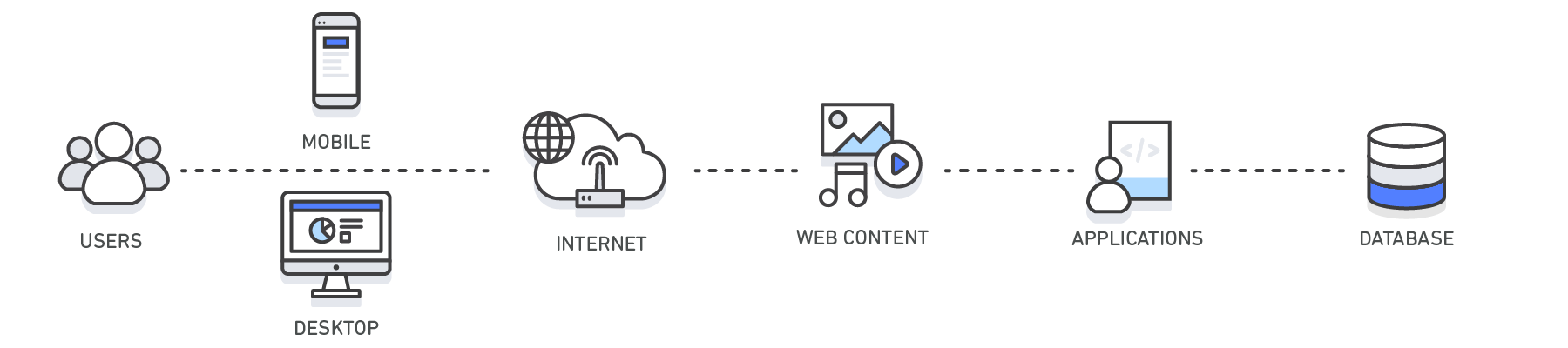

Nell'ambito dell'elaborazione, la cache è un livello di storage dei dati ad alta velocità che memorizza un sottoinsieme di dati, in genere di natura temporanea, per rispondere alle richieste più rapidamente di quanto non sarebbe possibile accedendo ogni volta al percorso principale in cui si trovano i dati. Il caching permette di riutilizzare in modo efficiente dati già recuperati o elaborati.

Come funziona il caching?

I dati nella cache vengono generalmente archiviati in hardware ad accesso rapido, ad esempio la RAM, e possono essere elaborati con l'ausilio di un componente software. Lo scopo principale della cache è aumentare le prestazioni di recupero dei dati riducendo la necessità di accedere al livello di storage successivo, più lento.

La cache sacrifica la capacità in favore della velocità, perciò in genere può memorizzare solo un sottoinsieme temporaneo di dati, mentre nei database i dati vengono memorizzati in modo completo e durevole.

Panoramica sul caching

| Livello | Lato client | DNS | Web | App | Database |

| Caso d'uso | Recupero più rapido di contenuti dai siti Web (browser o dispositivo) |

Risoluzione di domini in IP | Recupero più rapido di contenuti da server Web o di applicazioni. Gestione di sessioni Web (lato server) | Prestazioni delle applicazioni e accesso ai dati migliorati | Riduzione della latenza associata alle richieste di query di database |

| Tecnologie | Intestazioni di cache HTTP, browser | Server DNS | Intestazioni di cache HTTP, CDN, reverse proxy, acceleratori Web, store chiave-valore | Datastore chiave-valore, cache locale | Buffer di database, datastore chiave-valore |

| Soluzioni | Specifiche per browser | Amazon Route 53 | Amazon CloudFront, ElastiCache per Redis, ElastiCache per Memcached, soluzioni di partner | Framework di applicazioni, ElastiCache per Redis, ElastiCache per Memcached, soluzioni di partner | ElastiCache per Redis, ElastiCache per Memcached |

Caching con Amazon ElastiCache

Amazon ElastiCache è un servizio web che semplifica distribuzione, funzionamento e ridimensionamento di cache e datastore in memoria nel cloud. Si tratta di un servizio che potenzia le prestazioni delle applicazioni Web facilitando il recupero delle informazioni dai datastore gestiti in memoria, molto più rapide dei database basati su disco. Scopri come implementare una strategia di caching efficace con questo whitepaper tecnico sul caching in memoria.